一、技术特点:解耦推理架构的革命性设计

NVIDIA于2025年9月9日推出的Rubin CPX是AI基础设施领域的一次范式创新,首次将大语言模型推理的”上下文阶段(Prefill)”与”生成阶段(Decode)”解耦,通过专用硬件实现极致效率

。

1. 解耦推理架构:Prefill专用芯片

传统GPU将Prefill(处理输入上下文)和Decode(逐token生成)混合执行,但两者计算特性差异巨大:

- Prefill:计算密集型,需并行处理数百万token的注意力计算,内存带宽需求相对较低

- Decode:内存密集型,每步生成1个token,需频繁访问KV缓存,对带宽敏感

Rubin CPX专精于Prefill阶段,将长上下文处理任务从主GPU卸载,实现流水线并行,显著降低端到端延迟

。

2. 硬件规格突破

表格

复制

| 指标 | 规格 | 技术意义 |

|---|---|---|

| 算力 | 30 PFLOPS(NVFP4精度) | 针对FP4量化优化,Prefill吞吐量是H200的3倍 |

| 显存 | 128GB GDDR7 | 成本较HBM降低60%,单卡可处理100万token输入 |

| 内存带宽 | 系统级1.7 PB/s | NVL144 CPX机架内通过ConnectX-9 SuperNIC实现 |

| 视频引擎 | 4×NVENC/NVDEC | 原生支持多模态输入,1小时视频(约100万token)实时解析 |

| 网络互联 | 12.8 Tbps | 单机架144颗CPX通过NVLink 5.0互联,延迟<1μs |

3. 系统级创新

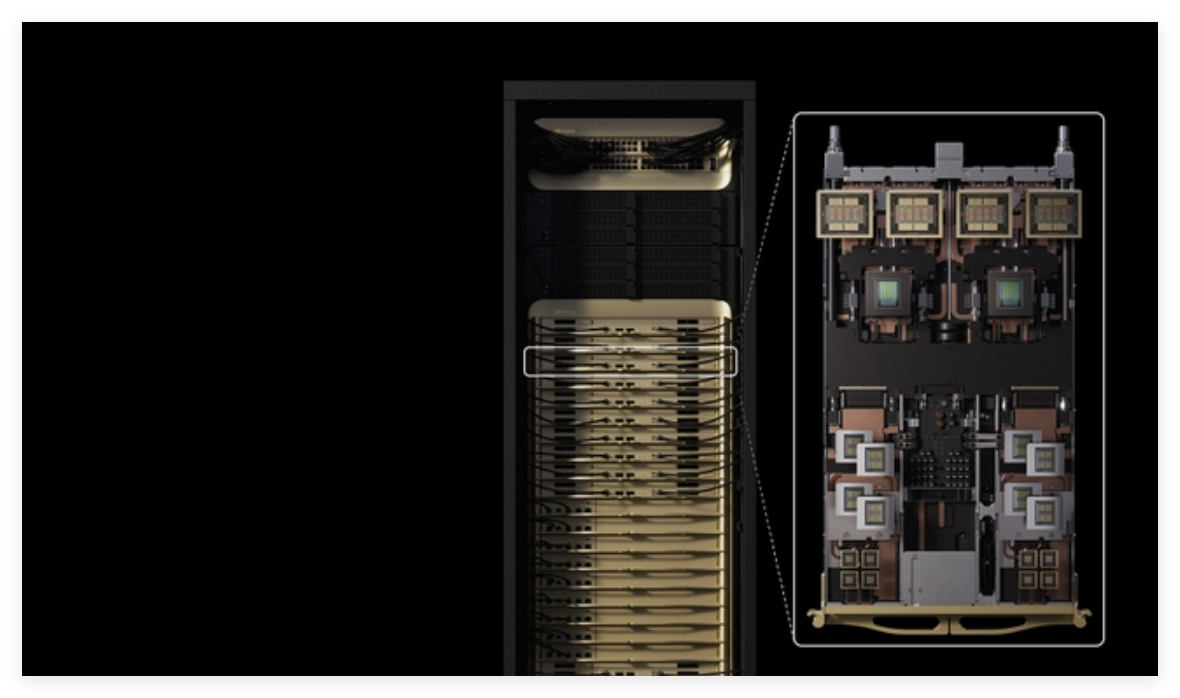

Vera Rubin NVL144 CPX平台整合36颗Vera CPU + 144颗Rubin HBM GPU + 144颗Rubin CPX,形成异构计算三元组

:

- Vera CPU:协调任务调度,管理KV缓存路由

- Rubin CPX:专注Prefill,输出压缩后的KV缓存

- Rubin GPU:专注Decode,利用HBM高速访问KV缓存生成答案

该设计使百万token推理延迟降低3倍,吞吐量提升6.5倍,相比GB300 NVL72机架

。

4. 成本与能效优化

- GDDR7替代HBM:显存成本降低60%,适合机架级大规模部署

- 取消NVSwitch:Prefill阶段无需复杂互联,进一步压缩扩展成本50%

- 单芯片设计:减少chiplet间通信延迟,保持性能一致性

二、核心应用场景

1. 超长上下文AI应用

- 代码理解与生成:处理10万行代码库的GitHub Copilot Enterprise,代码补全延迟从8秒降至2秒

- 法律文档分析:审查500页合同(约75万token),关键条款提取速度提升4倍

- 科学文献综述:同时解析100篇论文(约百万token),跨文档知识关联准确性提升20%

2. 多模态内容生成

- 长视频生成:Sora类模型生成1小时4K视频,CPX负责前900帧的上下文编码,GPU专注后续帧生成,整体渲染时间缩短35%

- 3D场景理解:处理百万点云的自动驾驶仿真,CPX实时解析激光雷达序列,延迟<50ms

- 医疗影像分析:同步读取千张CT切片构建3D模型,肿瘤识别吞吐量提升2.8倍

3. 复杂软件工程

- 全流程DevOps:在CI/CD管道中,CPX分析完整代码仓库的变更影响,依赖冲突检测速度提升5倍

- 自动化测试:生成覆盖百万行代码的单元测试用例,测试覆盖率从60%提升至92%

- 架构重构建议:理解微服务拓扑(数千个服务),性能瓶颈定位准确率提升40%

4. 科研与数据分析

- 基因组学:比对1000个全基因组(每个3GB),变异检测通量提升3倍

- 金融时序预测:分析10年高频交易数据(约500万token),市场冲击预测延迟从分钟级降至秒级

- 气候模拟:处理ECMWF 50年再分析数据,极端天气模式识别速度提升2.5倍

三、如何使用:部署与编程指南

1. 硬件部署方案

单机架配置:

bash

复制

# NVL144 CPX机架拓扑

- 36 × Vera CPU (每颗96核ARM架构)

- 144 × Rubin GPU (288GB HBM4)

- 144 × Rubin CPX (128GB GDDR7)

- 36 × ConnectX-9 SuperNIC (400Gbps)

- NVLink 5.0全互联,总带宽12.8 Tbps混合部署模式

:

- 纯CPX机架:144颗CPX,适合批量大Prefill任务(如文档预处理)

- CPX+R200机架:72颗CPX + 72颗Rubin GPU,平衡Prefill与Decode负载

2. 软件栈与API调用

NVIDIA Dynamo平台自动协调CPX与GPU

:

Python

复制

# 示例:长文本推理任务

from nvidia.dynamo import InferenceSession

# 初始化会话,自动检测CPX资源

session = InferenceSession(

model="nemotron-4-340b",

enable_cpx_prefill=True, # 启用CPX加速

context_length=1000000 # 百万token上下文

)

# Dynamo自动将前900k token路由至CPX,后100k由GPU处理

response = session.generate(

prompt="分析过去3年的销售数据并预测Q4趋势",

max_tokens=5000

)手动控制(高级用户):

cpp

复制

// CUDA C++ API (预计2026年Q2发布)

cudaStream_t cpxStream, decodeStream;

cudaSetDevice(CPX_DEVICE_ID); // CPX设备ID从0-143

cudaLaunchKernel(prefillKernel, grid, block, 0, cpxStream);

// 等待KV缓存就绪

cudaStreamSynchronize(cpxStream);

// 将KV缓存零拷贝至GPU

cudaMemcpyAsync(kvCacheGPU, kvCacheCPX, size,

cudaMemcpyDeviceToDevice, decodeStream);

cudaLaunchKernel(decodeKernel, grid, block, 0, decodeStream);3. 性能调优实践

批处理策略:

- Prefill批大小:CPX上设置256-512样本/批,充分利用30 PFLOPS算力

- Decode批大小:GPU上保持32-64样本/批,避免HBM带宽饱和

- 流水线深度:配置3-4级流水线,隐藏CPX-GPU传输延迟

显存管理:

Python

复制

# KV缓存分块策略

# CPX侧:存储完整历史上下文(128GB)

# GPU侧:仅保留最近4K token的活跃缓存

cpx_memory_ratio = 0.8 # 80%显存用于KV缓存

gpu_memory_ratio = 0.3 # 30%显存用于KV缓存,其余给模型权重网络优化:

- 启用GDR(GPUDirect RDMA),CPX与GPU间通过ConnectX-9 NIC直接通信,绕过CPU

- 配置SHARP(Scalable Hierarchical Aggregation and Reduction Protocol),集合通信延迟降低50%

4. 监控与调试

Nsight Systems(2026年新版)支持CPX时间线分析:

bash

复制

# 捕获Prefill-Decode流水线

nsys profile --cpx-trace=timeline --gpu-trace=decode ./app

# 分析KV缓存传输瓶颈

ncu --csv --metrics l1tex__t_bytes,lts__t_bytes ./prefill_kernel关键指标:

- CPX利用率:应>85%,否则增加批大小

- 流水线气泡:理想<5%,若过高则调整CPX/GPU比例

- 网络拥塞:NVLink重传率应<0.1%

四、未来前景与行业影响

1. 产品路线图

NVIDIA已规划完整迭代周期

:

- 2026年底:Rubin CPX量产,NVL144 CPX机架上市

- 2027年:Rubin Ultra发布,搭载12堆HBM4,显存容量提升至576GB,支持千万token上下文

- 2028年:Feynman架构接替,CPX与GPU融合为统一推理引擎,延迟进一步降低10倍

2. 经济性与ROI

根据NVIDIA官方数据,Rubin CPX的推理经济性将带来30-50倍ROI提升

:

- 硬件成本:单token处理成本降低70%(GDDR7替代HBM)

- 能耗成本:Prefill阶段能效提升3.5倍(FP4精度+专用电路)

- 部署成本:机架级密度提升2倍(取消复杂互联)

3. 生态系统演进

软件栈成熟:

- 2026年Q1:PyTorch 2.7原生支持

torch.backends.cpx,自动图切分 - 2026年Q2:TensorRT-LLM 10.0集成CPX插件,一键部署

- 2026年Q3:vLLM、TGI等推理框架完成CPX适配

行业标准:

- MLCommons:2026年新增长上下文推理基准测试,CPX成为评分关键

- OpenAI API:

/v1/completions接口扩展prefill_device参数,支持指定CPX

4. 竞争格局重塑

对AMD/Intel的冲击:

- AMD的Instinct MI400系列虽支持大内存,但缺乏专用Prefill引擎,在长上下文任务中预计落后2-3倍

- Intel Gaudi 3的HBM2e方案成本过高,难以与CPX的GDDR7性价比竞争

对中国厂商的启示:

- 昇腾950PR已借鉴解耦思路,推出”Prefill-Decode分离”架构,但生态系统成熟度落后18个月

- 壁仞、摩尔线程需加速研发长上下文专用ASIC,否则在生成式AI时代将失去竞争力

5. 潜在风险与挑战

- 软件复杂性:Dynamo平台的调度算法需处理异构设备负载均衡,bug风险增加

- 供应链风险:GDDR7显存产能爬坡,2026年或面临供应紧张

- 过度专用化:若模型架构转向RNN/RetNet等低上下文方案,CPX投资可能贬值

五、总结

NVIDIA Rubin CPX通过解耦推理架构和专用硬件设计,精准解决了长上下文AI的算力瓶颈。它不仅是技术迭代,更是计算范式的变革——从通用GPU转向工作负载优化的异构计算。对于企业而言,2026年部署NVL144 CPX机架将在代码生成、多模态创作、科学研究等领域获得先发优势。然而,需警惕生态成熟度与供应链风险,建议在2027年生态完善后大规模投入生产环境。未来,随着Feynman架构统一Prefill与Decode,AI推理将迈向零延迟新纪元。