——从算力竞争到存储带宽与容量的真实战场

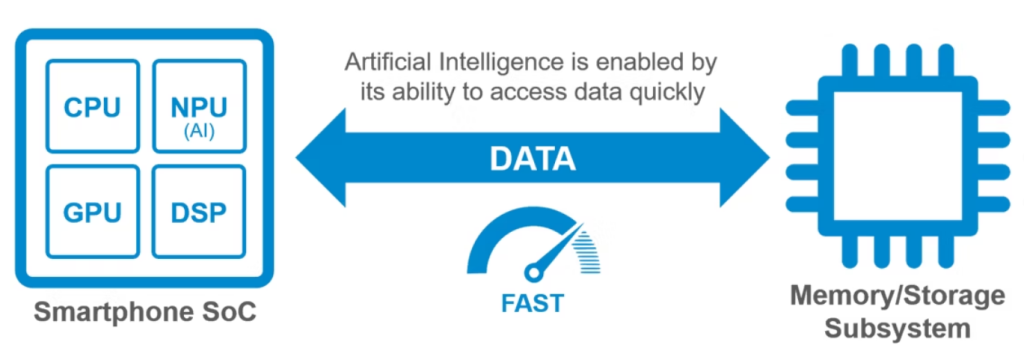

为什么 AI 计算对存储“胃口”大开?

AI 计算不是一次性的读取,而是一个高频、循环的“吞吐”过程。它对存储的要求主要体现在以下两个维度:

1. 存储带宽:告别“算力饥饿”

- GPU starvation(GPU 饥饿): 在训练大模型时,GPU 需要每秒读取数 GB 甚至数十 GB 的数据进行计算。如果存储带宽不足,昂贵的 H100/B200 集群将长时间处于等待数据的“闲置”状态,造成极大的资源浪费。

- 数据预处理压力: AI 工作流包含“采集-清洗-训练-推理”。在预处理阶段,海量小文件的随机读取对 IOPS 和带宽提出了近乎苛刻的要求。

2. 存储容量:海量数据的“容身之所”

- 数据集膨胀: 从文本到多模态(图像、视频),训练数据集已从 TB 级跨越到 PB 级。

- Checkpoints(模型快照): 为了防止长达数月的训练因硬件故障中断,系统需要频繁保存“断点(Checkpoints)”。一个万亿参数模型的单次快照可能就达数 TB,且需要极高的写入带宽以减少停机时间。

核心技术与工具软件

为了应对这些挑战,存储架构正在发生翻天覆地的变化:

- 核心算法与协议:

- GPUDirect Storage (GDS): 由 NVIDIA 推出,允许数据绕过 CPU 和系统内存,直接从 NVMe 存储传输到 GPU 显存,延迟降低 50%,带宽提升数倍。

- RDMA (远程直接内存访问): 在分布式集群中实现节点间存储数据的超低延迟交换。

- 主流工具软件:

- 并行文件系统 (Lustre / BeeGFS / Weka): 专为 HPC 和 AI 设计,支持成千上万个客户端同时高速读写。

- 对象存储 (MinIO / Ceph): 凭借极强的横向扩展能力,成为存储 PB 级原始数据集的首选。

典型应用场景

| 场景 | 存储侧重点 | 建议方案 |

| LLM 大模型训练 | 极致带宽、快速快照写入 | 全闪存 NVMe 阵列 + 并行文件系统 |

| 自动驾驶仿真 | 极高并发随机读取 (海量图片/雷达数据) | 层次化存储 (冷热数据自动分层) |

| 智慧医疗 (基因/影像) | 大容量存储、数据合规性 | 高密度对象存储 + 归档备份 |

2025 最新硬件配置架构推荐

要构建一套不拖后腿的 AI 存储系统,硬件架构必须领先一步:

- 存储介质: 全面进入 PCIe 5.0 时代。企业级 SSD 如 Micron 9550 或 WD Black SN8100,单盘顺序读取已突破 14GB/s。

- 新型架构: CXL (Compute Express Link) 内存池化技术正在落地,允许存储、内存与 CPU/GPU 之间实现更灵活的带宽分配。

- 网络互联: 存储网络从 100GbE 进化至 400Gb/s InfiniBand 或 800Gb/s 以太网,确保数据“油管”足够粗。

推荐配置参考(万亿参数训练级):

- 热数据层: 32个 NVMe Gen5 节点,组成并行文件系统,提供 500GB/s+ 的聚合带宽。

- 冷数据层: PB 级对象存储,采用 QLC 颗粒平衡成本与容量。

- 互联: NVIDIA Quantum-2 InfiniBand 交换机,支持多路冗余。

结语

在 AI 时代,“存”得快才能“算”得快。投资顶级的 GPU 固然重要,但构建一套高带宽、大容量、低延迟的存储底座,才是保障业务连续性和投资回报率(ROI)的关键所在。