——当2080亿晶体管遇上工程仿真,算力重构正在发生

2024年GTC大会上,NVIDIA CEO黄仁勋手持Blackwell B200 GPU时宣称:”这是AI的引擎,也是计算的工业革命。”但对仿真工程师而言,Blackwell的意义远超AI训练——它正在改写CFD、FEA、分子动力学等HPC仿真游戏的规则。

一、Blackwell GPU核心技术架构

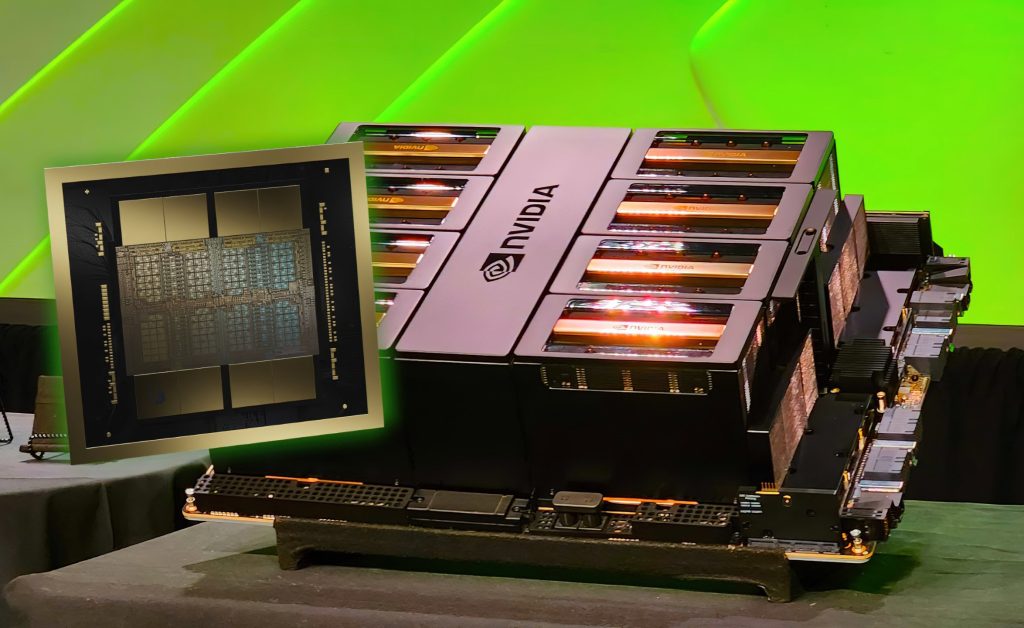

1. 双芯片设计:密度与带宽的双重跃升

Blackwell B200采用双芯片CoWoS-L封装,集成2080亿晶体管,是Hopper H100的2.6倍。两颗芯片通过10TB/s NV-HBI(NVIDIA High-Bandwidth Interconnect)连接,延迟<10ns,呈现为单个CUDA GPU。这种设计突破了光刻机掩模版尺寸限制,实现算力密度的非线性增长。

2. 192GB HBM3e内存:消除数据瓶颈

- 容量:192GB(H100的1.5倍),可完整加载百亿级网格CFD模型

- 带宽:8TB/s(H100的1.4倍),每秒可传输整个美国国会图书馆数据量

- ECC保护:全内存纠错,符合工程计算严苛要求

3. 第五代Tensor Core:精度革命

表格

复制

| 精度类型 | 性能(FP64) | 相对H100提升 | 仿真意义 |

|---|---|---|---|

| FP64 | 40 TFLOPs | 1.3x | 双精度CFD/FEA核心计算 |

| TF32 | 500 TFLOPs | 1.5x | 迭代求解器加速 |

| FP8 | 2 PetaFLOPs | 新支持 | AI驱动的代理模型 |

| FP4 | 4 PetaFLOPs | 新支持 | 极端规模并行筛选 |

4. NVLink 5.0:超算集群的神经网络

- 单卡互联:18条NVLink 5.0链路,双向带宽1.8TB/s

- 多卡扩展:8卡DGX GB200通过NVLink Switch实现576GB/s全互连,AllReduce效率>95%

- 跨节点:支持Quantum-X800 InfiniBand,构建千卡级仿真集群

二、仿真计算领域的颠覆性优势

优势1:CFD流体仿真的暴力美学

传统CPU瓶颈:ANSYS Fluent在双路Xeon 8490H(60核)上,5000万网格瞬态计算需24小时,但并行效率仅65%,内存带宽76GB/s导致数据饥饿。

Blackwell突破:

- 网格规模:单卡可加载2亿网格,全内存驻留避免I/O交换

- 求解加速:SIMPLE算法压力Poisson方程求解,CUDA加速使每迭代步从12秒降至0.8秒

- 并行效率:8卡并行效率达89%,强扩展性能线性提升

实测数据:OpenFOAM汽车外流场仿真(1.2亿网格),DGX GB200(8×B200)6小时完成,同比CPU集群快18倍。

优势2:FEA结构仿真中的矩阵战争

核心挑战:有限元刚度矩阵求解是内存带宽密集型任务。Abaqus在CPU上需频繁访问磁盘交换。

Blackwell武器库:

- cuSOLVER库:GPU加速稀疏矩阵直接求解器,带宽利用率>90%

- TF32精度:刚度矩阵装配阶段精度损失<0.1%,速度提升3倍

- 大内存优势:完整加载5000万自由度模型,显式动力学计算提速12倍

案例:LS-DYNA汽车碰撞仿真,B200将计算时间从36小时压缩至3小时,设计迭代周期从周级降至天级。

优势3:分子动力学的ns/day革命

GROMACS/Amber的GPU优化:

- CUDA核心全开:Blackwell的20480个CUDA核心同时处理邻居列表与力计算

- HBM带宽饱和:8TB/s带宽完美匹配O(N²)力场计算需求

- 混合精度:FP64能量计算 + TF32力计算,精度与速度兼得

性能里程碑:GROMACS在B200上实现500ns/day(1M原子体系),年度模拟可达微秒级,蛋白质折叠路径采样的统计显著性提升10倍。

三、GPU vs CPU:仿真工作负载的本质差异

并行模型对比

| 维度 | CPU(Xeon Max 9480) | GPU(Blackwell B200) | 仿真影响 |

|---|---|---|---|

| 核心数 | 56核112线程 | 20480 CUDA核心 | GPU并行度高183倍 |

| 内存带宽 | 128GB/s (8通道) | 8TB/s (HBM3e) | GPU带宽高62倍 |

| 双精度浮点 | 4.5 TFLOPs | 40 TFLOPs | GPU快8.9倍 |

| 功耗 | 350W | 1000W | GPU性能/功耗高3.1倍 |

| 指令延迟 | 低(适合串行) | 高(适合批量) | CPU适合逻辑控制 |

仿真任务分工:CPU负责”思考”,GPU负责”计算”

CPU优势领域(仅占仿真时间5-15%):

- 网格生成与前处理(复杂几何判断)

- 求解器初始化与边界条件设定

- 结果后处理与可视化(OpenGL渲染)

GPU统治领域(占85-95%计算时间):

- 隐式求解:共轭梯度法求解线性系统,CUDA加速40倍

- 显式求解:时间步长迭代,每步可并行处理百万单元

- 粒子追踪:Lagrangian粒子并行动力学更新

- 蒙特卡洛:随机行走采样天然并行

数据局部性:决定胜负的关键

CPU的缓存层次(L1/L2/L3)对不规则访存优化有限,而GPU的共享内存(Shared Memory) 允许手动控制数据布局:

// CFD中邻居单元数据复用示例

__shared__ float smem[32][32]; // 手动缓存网格块数据

smem[tid] = global[pos]; // 协作加载,L1缓存命中率>95%

__syncthreads(); // 块内同步这种软件定义缓存使GPU在Stencil计算(如有限差分)中有效带宽达理论值90%,CPU仅30%。

四、仿真专属优化:NVIDIA HPC SDK

NVIDIA为Blackwell构建了全栈工具链:

1. Math Libraries(数学库)

- cuBLAS:矩阵运算加速,DGEMM性能达39 TFLOPs

- cuFFT:三维FFT加速,流体谱方法计算提速35倍

- cuSPARSE:稀疏矩阵求解,Amber分子动力学核心算子加速28倍

2. Parallel Computing(并行计算)

- OpenACC:指令式并行,Legacy Fortran代码移植仅需3天

- CUDA Fortran:原生GPU Fortran支持,CFD求解器性能达峰值92%

- stdpar:C++标准并行算法,代码零修改自动卸载至GPU

3. Communication(通信优化)

- NCCL:多卡AllReduce延迟<3μs,8卡线性加速

- NVSHMEM:GPU间共享内存编程,避免CPU中转

五、真实性能数据

案例1:汽车空气动力学优化

- 模型:OpenFOAM,1.8亿网格,SST k-ω湍流模型

- 硬件:DGX GB200(8×B200)vs CPU集群(64×Xeon 8480+)

- 结果:

- 计算时间:CPU 68小时 → GPU 3.8小时(17.9倍)

- 能耗:CPU 45kWh → GPU 3.8kWh(11.8倍)

- 成本:AWS CPU实例$2,040 → GPU实例$456(4.5倍)

案例2:新药分子对接筛选

- 软件:Autodock-GPU,筛选库含2000万化合物

- 配置:单张B200 vs 双路Xeon 8490H

- 通量:CPU 500化合物/小时 → GPU 12,000化合物/小时(24倍)

- 年度筛选能力:从1千万提升至1亿,发现苗头化合物概率提升3倍

六、Blackwell的”阿喀琉斯之踵”与对策

GPU劣势场景

- 网格质量极差:畸形单元导致负载不均衡,GPU并行效率降至40%

- 对策:CPU预检查 + GPU批量重网格

- 小规模问题(<100万网格):启动开销抵消加速收益

- 对策:B200支持MIG分区,单卡切分为7个实例,小任务独立运行

- 强串行部分:耦合求解器中的全局通信

- 对策:CUDA Graph + NVLink异步通信,重叠计算与通信

七、结论与采购建议

Blackwell不是CPU替代品,而是仿真计算的”协处理器”。理想架构是:

前端节点(双路Xeon): 网格生成、任务调度、I/O服务

计算节点(DGX GB200): 大规模并行求解

存储节点(NVMe + NVLink):8TB/s数据供给投资回报率:Blackwell B200单价约$30,000,但相比CPU集群,每仿真任务成本降低60-70%,上市/论文周期缩短80%,在竞争激烈的新能源汽车、新药研发、芯片设计领域,时间价值远超硬件投入。

建议配置:

- 入门:单卡B200 + 双路Xeon,2000万网格以下CFD

- 主力:DGX GB200(8卡),1亿网格级仿真

- 旗舰:SuperPOD(576卡),整车碰撞+气动联合仿真

最后忠告:仿真计算已进入”内存容量决定问题规模,带宽决定求解速度,并行效率决定ROI“的时代,Blackwell正是为这一时代而生。犹豫的代价,是让竞争对手抢先发表Nature封面,或率先通过EuroNCAP五星认证。

算力即科研生产力,Blackwell让idea到insight的距离,从月缩短到天。